Page 45 - 清流雙月刊 NO.53

P. 45

AI 時代

潛在的危害,包含對人、對企業、對生態 標準,提供快速變化的 AI 技術領域一個管

系統,兩者對應整理如表 1。 理制度,其管理重點包括:

一、確認組織目標:組織需要確定其目標,

AI 管理系統 ISO/IEC 42001:2023

並考慮到利益相關者的參與和組織政策。

國際標準組織於 2023 年 12 月 18 日

二、管理風險和機會:組織需要管理與 AI

推出 ISO/IEC 42001:2023 人工智慧管理系

相關的風險和機會,以提高 AI 系統的

統正式版,這是世界上第一個 AI 管理系統

整體效能和效率。

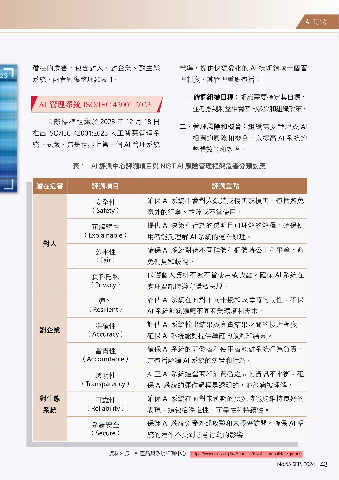

表 1 AI 評測中心評測項目與 NIST AI 風險管理框架危害分類對應

潛在危害 評測項目 評測重點

安全性 確保 AI 系統不會對人類造成傷害或損害。包括避免

(Safety) 意外的行為、故障或不當使用。

可解釋性 提供 AI 決策和行為的透明且可理解的解釋。確保使

(Explainable) 用者能夠理解 AI 系統的運作原理。

對人

公平性 確保 AI 系統對待不同群體和個體時公正和平等。避

(Fair) 免偏見和歧視。

資料隱私 保護個人資料不被不當使用或洩露。確保 AI 系統在

(Privacy) 處理資訊時遵守隱私法規。

彈性 評估 AI 系統在面對不同干擾和故障時的韌性。確保

(Resilient) AI 系統能夠適應不同商業環境和需求。

準確性 評估 AI 系統輸出結果與真實結果之間的接近程度。

對企業

(Accuracy) 確保 AI 系統能夠提供準確的預測和結果。

當責性 確保 AI 系統的開發者和使用者能對系統行為負責。

(Accountable) 這包括解釋 AI 系統的決策和行為。

透明性 糾正 AI 系統運營商和消費者之間的資訊不平衡。確

(Transparency) 保 AI 系統的運作過程是透明的,並能夠被理解。

對生態 可靠性 確保 AI 系統在面對未預期的狀況時能夠維持良好的

系統 (Reliability) 表現。這包括穩定性、可靠性和持續性。

系統安全 保護 AI 系統免受外部攻擊和未授權訪問。確保 AI 系

(Secure) 統的運作不受到惡意行為的影響。

資料來源:AI 產品與系統評測中心,https://www.aiec.org.tw/AboutUs/EstablishmentBackground。

No.53 SEP. 2024 43