Page 57 - 清流雙月刊 NO.49

P. 57

AI 世代

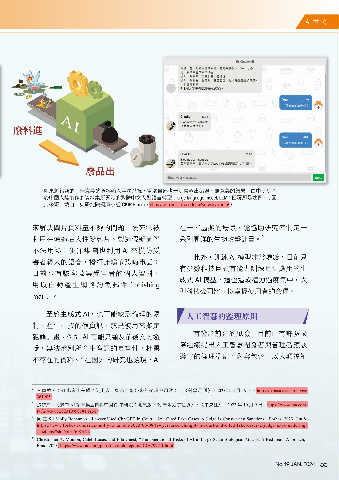

廢料進

廢品出

如果將錯誤的、無意義的資料輸入電腦系統,電腦自然也一定會輸出錯誤、無意義的結果;由中研院基

於中國大陸製作的資料集所開發的繁體中文大型語言模型(large language model, LLM)回覆即是適例。(圖

片來源:截自中央研究院詞庫小組 CKIP Bloom,https://ckip.iis.sinica.edu.tw/service/bloom/)

來解決圖片資料量不夠的問題,後來卻被 在一些虛擬的場景,能協助研究者制定一

9

利用在偽造名人性愛影片、製造假新聞等 系列周詳的生物攻擊計畫。

不法用途;犯罪集團也利用 AI 來模仿受

此外,訓練 AI 模型非常燒錢,目前只

害者親人的語音,撥打詐騙或恐嚇電話;

有少數科技巨頭有能力訓練足堪應用的生

日前也有駭客蒐集受害者的個人資料,

成式 AI 模型,這也造成權力過度集中,大

用以自動產生網路釣魚郵件(phishing

型科技公司將可以掌握使用者的命運。

mail)。

至於生成式 AI,也可能缺乏倫理的限 人工智慧的監理原則

制,產生杜撰的假資訊,或是被用來擬定

有鑒於前述的風險,目前已有許多國

犯罪計畫。例如 AI 可能只顧及前後文的邏

際組織提出人工智慧開發者與管理者應該

輯,無法辨別所產生資訊的真實性,杜撰

遵守的倫理準則,內容包含:以人類福祉

8

不存在的資料。 在國外的研究也發現,AI

6 甘偵蓉,〈AI 也會出差錯?使用人工智慧可能帶來的倫理與風險〉,《科學月刊》,2023 年 2 月 19 日,https://pansci.asia/archives/

361905。

7 張雄風,〈繁中 AI 語言模型自稱中國籍 中研院:測試版下架 未來力求謹慎〉,《中央社》,2023 年 10 月 9 日,https://www.cna.com.

tw/news/ait/202310090181.aspx。

8 同註 5;Molly Bohannon, “Lawyer Used ChatGPT In Court—And Cited Fake Cases. A Judge Is Considering Sanctions,” Forbes, 2023, Jun 8,

https://www.forbes.com/sites/mollybohannon/2023/06/08/lawyer-used-chatgpt-in-court-and-cited-fake-cases-a-judge-is-considering-

sanctions/?sh=55d37ef87c7f.

9 Christopher A. Mouton, Caleb Lucas, and Ella Guest, “The Operational Risks of AI in Large-Scale Biological Attacks: A Red-Team Approach,”

Rand, 2023, https://www.rand.org/pubs/research_reports/RRA2977-1.html.

No.49 JAN. 2024 55